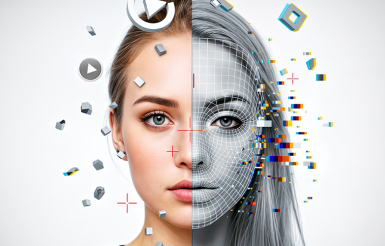

Mon manager est un robot : l’IA en gestion des ressources humaines

25 mars 2022

Les techniques d’ sont parfois utilisées pour la gestion de ressources humaines, par exemple comme outil d’aide à la décision. Les employeurs doivent veiller à garantir un équilibre entre amélioration des performances, protection des données et management de qualité.

Certaines grandes entreprises disposant d’importantes bases de données utilisées pour la gestion des ressources humaines souhaitent utiliser ces informations pour améliorer leurs procédures, gagner en efficacité. Les méthodes appliquées à ces données posent des questions au regard du RGPD mais également sur leur influence sur le management des employés.

Certains logiciels de gestion RH proposent par exemple des solutions pour prédire le roulement (turn over) en avançant l’hypothèse que certaines données RH telles que le salaire, la date d’embauche, les notes d’évaluation ou encore la satisfaction exprimée par l’employé, sont corrélés avec le risque de départ volontaire. Ce type d’outil répond au fait que le coût d’embauche d’un employé est bien plus important que le coût de rétention. Ainsi, prédire le départ des employés permettrait de mettre en place la stratégie adaptée pour éviter les départs des meilleurs éléments.

Afin d’effectuer cette prédiction, plusieurs algorithmes peuvent être utilisés, et parmi eux la forêt d’arbres décisionnels ou random forest. Cette méthode appartenant au domaine de l’apprentissage machine est un algorithme ou de multiples arbres décisionnels traitent les informations qu’on leur fournit pour prédire un résultat : on parle de classification. Les nombreux paramètres contenus dans les arbres décisionnels sont entraînés afin de représenter la logique sous-jacente à l’ensemble de données fourni à l’.

En revanche, certains facteurs moins évidents pourraient être mis en évidence par l’algorithme : une équipe majoritairement composée de personnes d’un certain sexe pourrait présenter un taux de roulement assez faible comparé au reste de l’entreprise pour des raisons externes au fonctionnement de l’entreprise. L’appartenance à l’équipe qui est corrélée à un meilleur taux de roulement (le plus faible) est donc révélatrice du genre des employés : une information non discriminatoire (le taux de roulement) se substitue à une autre bien discriminatoire (le genre des employés). L’entreprise pourrait ainsi logiquement choisir d’augmenter le salaire des autres équipes, au détriment de la première, et créerait ainsi une discrimination.

Ici, même si le ne prend pas la décision finale, l’automatisation du processus peut rendre la supervision humaine inopérante en l’absence d’une bonne connaissance de l’outil ou de pondération des suggestions qu’il fait : on parle alors de biais d’automatisation. L’utilisation de ces algorithmes doit ainsi être accompagnée de certaines précautions.

De nombreux cas de discrimination similaires ont été notés. On peut citer par exemple le cas des algorithmes de recrutement entraînés sur des CV appartenant majoritairement à des hommes, qui écartaient les CV de candidates car leur profil ne correspondait pas à celui attendu.

Où ces méthodes sont-elles utilisées ?

- Gestion RH : pour la prédiction du roulement, mais également l’aide au recrutement et la gestion managériale plus généralement.

- Banque et assurance : pour l’attribution de prêts, de politiques d’assurance, pour le calcul de taux d’intérêt, etc.

Quels sont les risques pour les personnes ?

- Une prise de décision ayant un effet sur moi pourrait être prise indirectement par un algorithme par manque d’information des superviseurs humains.

- La mise en œuvre de ce type de méthode peut entraîner des pratiques discriminatoires quand bien même la donnée directement discriminante n’est pas utilisée.

Quelques conseils de la CNIL

Pour l’entreprise

- Toujours maintenir une supervision par l’humain lors de l’utilisation d’un algorithme en tenant compte du biais d’automatisation.

- Informer clairement les employés lorsqu’une décision les concernant est prise grâce à un traitement automatisé.

- Favoriser l’explicabilité et explorer les modalités permettant de s’assurer de l’absence de biais lors de la conception de l’algorithme.

Pour l’individu

- Interroger le service RH de mon entreprise sur l’utilisation de mes données.

- Demander plus de transparence à mon entreprise, ma banque, mon assurance sur l’utilisation de traitements automatisés.

Vous souhaitez contribuer ?

Écrivez à ia[@]cnil.fr